|

• Capacidade de resolução da imagem

Quanto mais fotocélulas e conseqüentemente

mais pixels, melhores serão os detalhes gravados e mais nítidas as imagens.

Se alguém ampliar e continuar ampliando qualquer imagem digital, chegará um

momento em que os pixels vão começar a aparecerem multifacetados (esse

efeito se chama pixelização). Portanto, quanto mais pixels existirem em uma

imagem, mais ela aceitará ampliações com qualidade; quanto menos pixels,

menor a ampliação possível.

Portanto, aqui está a diferença básica entre modelos de câmeras digitais

(e seus preços): a capacidade de resolução da imagem (e sua subseqüente

qualidade e tamanho final). Outras diferenças são pertinentes à quantidade

de recursos disponíveis na câmera e seu grau de automação ou possibilidade

de ajustes manuais.

Voltando a falar sobre resolução, como vimos, os sensores de imagens

contém uma teia (ou grade) de fotocélulas, cada uma delas representando um

pixel na imagem final - assim a resolução de uma câmera digital é

determinada pela quantidade de fotocélulas que existem na superfície de seu

sensor. Por exemplo, uma câmera com um sensor no qual cabem 1600 (largura) x

1200 (altura) fotocélulas gera uma imagem de 1600 x 1200 pixels. Então, para

efeito de terminologia e definição da capacidade de uma câmera, dizemos

simplesmente que ela tem uma resolução de 1600 x 1200 pixels, ou 1,92

megapixels.

Atualmente as câmeras mais simples geram arquivos de 640 x 480 pixels,

enquanto câmeras de capacidade média estão por volta de 1600 x 1200 pixels,

e câmeras de ponta produzem imagens de 2.560 x 1.920 pixels (perto de 5

megapixels). Importante notar que isto se refere às câmeras amadoras, pois

algumas profissionais já produzem mais de seis milhões de pixels. Quanto

maior a capacidade de resolução, geralmente maior também o preço.

Outro detalhe importante é que quanto maior a imagem em pixel, maior o

tamanho do arquivo resultante. Por isso, normalmente as câmeras digitais

possuem uma regulagem para o tamanho do arquivo, dando a opção para o

fotógrafo de escolher o modo de resolução. Assim, se alguém vai capturar

imagens para a WEB e possui uma câmera de 3.3 megapixels, pode regulá-la

para gerar imagens de apenas 640 x 480 pixels, bem mais fáceis de armazenar

e lidar. Por exemplo, uma câmera de alta resolução, 2048 x 1560 pixels, gera

uma imagem média em arquivo JPEG (depende das tonalidades e intensidade de

luz retratadas) de aproximadamente 1,2 MB (megabytes). Já na resolução de

640 x 480 pixels, no mesmo formato JPEG, gerará um arquivo de apenas 220 Kb

(kilobytes), ou seja, menos de 1/5 do tamanho.

Além da preocupação com espaço de armazenamento e rapidez em transmissão

pela Internet, em termos práticos deve-se levar em conta o tamanho com o

qual se pretende imprimir a imagem. Ainda seguindo os exemplos acima, a

imagem de 2048 x 1560 pixels (3.3 MB) pode ser impressa, sem qualquer perda,

em alta resolução (300 dpi), no tamanho de 17,34 x 13 cms, enquanto a imagem

de 640 x 480 pixels permite apenas uma boa imagem impressa no tamanho 5,42 x

4,06 cms. Como se calcula o tamanho em termos de resolução é assunto que

trataremos mais adiante neste curso, quando abordarmos a impressão.

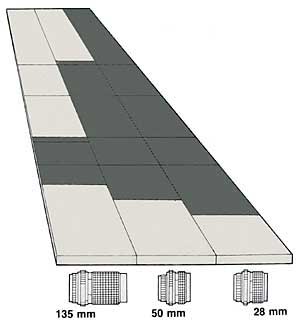

| Resolução |

Tamanho em pixels |

Tamanho do arquivo |

Tamanho da impressão |

|

300 dpi |

640x480 |

938.292 bytes |

5,42x4,06 cm |

|

300 dpi |

800x600 |

1.456.648 pixels |

6,77x5,08 cm |

|

300 dpi |

1024x768 |

2.375.728 bytes |

8,67x6,50 cm |

|

300 dpi |

1600x1200 |

5.375.728 bytes |

13,55x10,16 cm |

|

300 dpi |

2048x1536 |

9.453.572 bytes |

17,34x13,00 cm |

|

Apesar de quanto maior o número de fotocélulas num sensor melhores

imagens serem produzidas, acrescentar simplesmente fotocélulas à um sensor

nem sempre é fácil e pode resultar em problemas. Por exemplo, para se

colocar mais fotocélulas num sensor de imagem, o sensor precisaria ser maior

ou as fotocélulas menores. Chips maiores com mais fotocélulas aumentam as

dificuldades de construção e os custos para o fabricante. Fotocélulas

menores, por outro lado, serão menos sensíveis e irão capturar menos luz que

as de um chip normal. Concluindo, colocar mais fotocélulas num sensor, além

de sua complexidade e alto custo, acaba resultando em arquivos maiores, de

difícil armazenamento. Por isso a constante corrida tecnológica entre os

fabricantes na busca de sensores de maior resolução, com qualidade e preço

competitivo.

• A tecnologia Foveon

Recentemente, em 2002, surgiu um novo tipo de sensor digital no mercado,

o Foveon X3, que por enquanto equipa apenas uma câmera digital, a Sigma SD9.

Este sensor, do tipo CMOS, é uma verdadeira revolução no mercado, pois

apresenta os sensores de imagem em camadas, e não mais num único nível com

três fotocélulas diferentes para capturar cada cor (como os CCDs comuns). A

vantagem desse sistema, que aproveita a capacidade do silício de absorver as

ondas de luz, é que permite ao sensor funcionar como um filme fotográfico

(que também captura a luz em camadas, embora tenha como sensor uma película

química). Assim, cada pixel é formado por todas as cores, e não por cálculos

e interpolações entre as informações colhidas por três fotocélulas

diferentes (o que gera perdas). Teoricamente, com isso obtêm-se mais

resolução, nitidez na imagem, e melhor amplitude de cores, igualando ou até

superando a qualidade da fotografia convencional.

Contudo, a tecnologia ainda está em seu começo, com o amadurecimento, se

for comprovada a sua eficiência, deve se constituir no futuro da fotografia

digital.

|

•

Fotografia digital

•

Fotografia digital

Macrofotografia fica versátil com câmeras

digitais

Macrofotografia fica versátil com câmeras

digitais

Capturar uma boa cena requer oportunidade

Capturar uma boa cena requer oportunidade Velocidade alta de obturador congela a imagem

Velocidade alta de obturador congela a imagem Momento decisivo, quando ações acontecem

Momento decisivo, quando ações acontecem A

área escura representa a profundidade de campo

A

área escura representa a profundidade de campo Obturador em 8 segundos e movimento de câmera

Obturador em 8 segundos e movimento de câmera

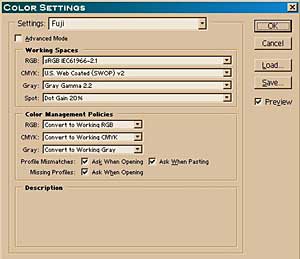

Eu,

particularmente, acerto a luminosidade e contraste de meu monitor

aproveitando que o laboratório digital, para o qual envio minhas fotos,

trabalha num determinado perfil de cor que é idêntico ao de minha câmera

digital. Assim, tenho assegurado que tanto a câmera digital como o

laboratório trabalham com as mesmas cores. A partir daí, pedi para o

laboratório enviar uma imagem fotográfica de amostra (conhecida como target).

Observando então a fotografia na tela e confrontando com a mesma imagem nas

mãos, pude ir acertando brilho, contraste e tonalidades.

Eu,

particularmente, acerto a luminosidade e contraste de meu monitor

aproveitando que o laboratório digital, para o qual envio minhas fotos,

trabalha num determinado perfil de cor que é idêntico ao de minha câmera

digital. Assim, tenho assegurado que tanto a câmera digital como o

laboratório trabalham com as mesmas cores. A partir daí, pedi para o

laboratório enviar uma imagem fotográfica de amostra (conhecida como target).

Observando então a fotografia na tela e confrontando com a mesma imagem nas

mãos, pude ir acertando brilho, contraste e tonalidades.